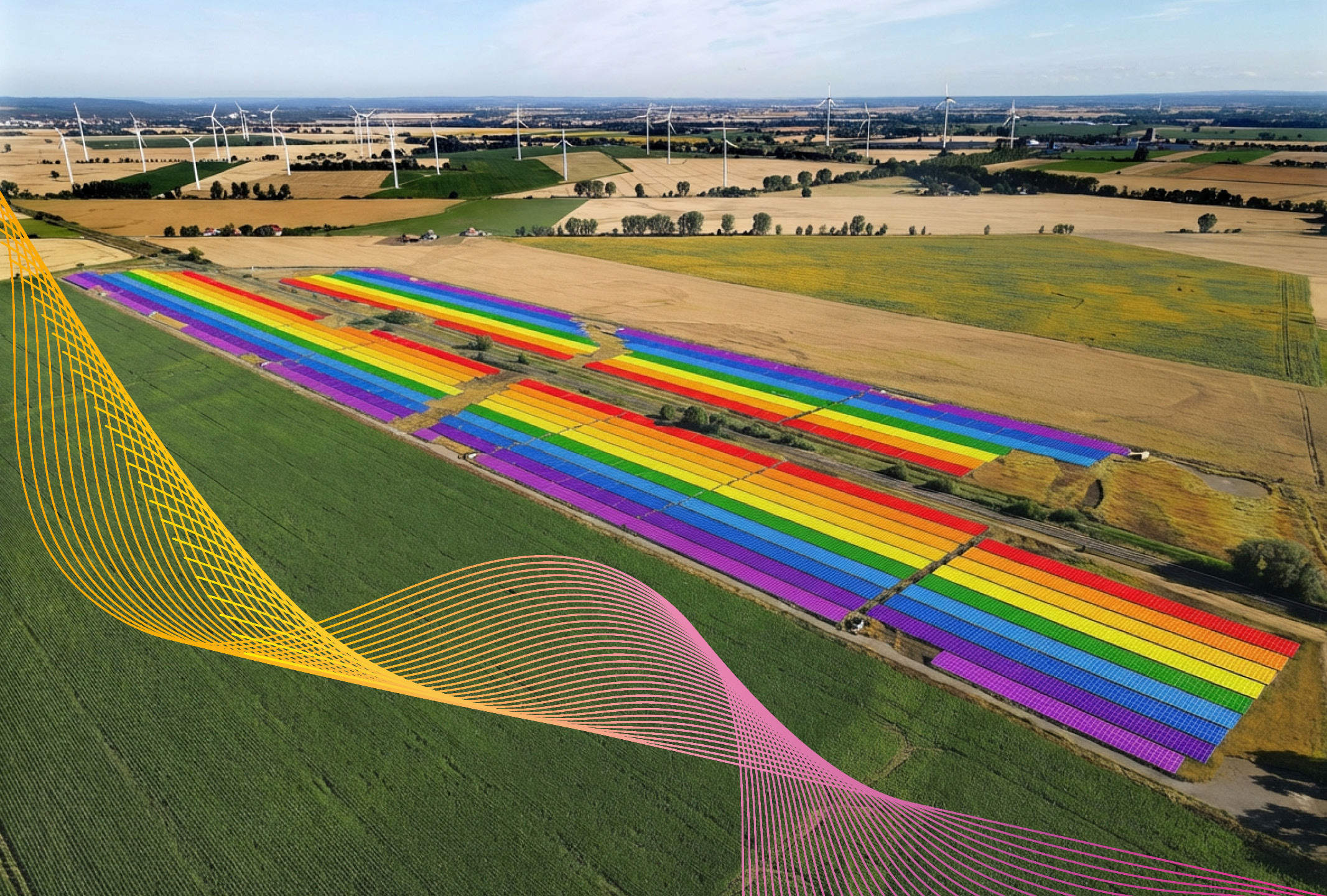

Mit „spatial intelligence“ zum Solarpark

Die Planung von ökologisch verträglichen und zeitgleich wirtschaftlich erfolgreichen Solarparks ist häufig eine langwierige Prozesskette. Die Potentialflächenanalyse – eine Multifaktoranalyse basierend auf aktuellen Satellitenbildern, Raumordnungsdaten, topographischen Charakteristiken und Netzinfrastrukturdaten – bildet hierbei den ersten Schritt, um die natur- und kulturräumlichen Charakteristiken der Region zu verstehen und um langfristig optimale Standorte auszuwählen.

Die Entscheidungsbasis einer Potentialflächenanalyse wird grundsätzlich durch Geodaten aufgebaut, die den spezifischen Merkmalsraum der Region repräsentieren. Zwischen der „Analyse mit Geodaten“ und einer tatsächlichen „spatial intelligence“ liegt jedoch ein hoher Aufwand.

Grundlegend ist immer die Arbeit in einem Geographischen Informationssystem (GIS), eine Software-Umgebung zur Erfassung, Speicherung und Visualisierung von Geodaten. Die Verwaltung der Datensätze, also das Geodatenmanagement, wird von diesen Systemen allerdings nicht übernommen. Damit zeigt sich die erste große Herausforderung auf dem Weg zur räumlichen Intelligenz.

Datenaktualität als Erfolgsfaktor:

Wer garantiert, dass die genutzten Geodaten nicht veraltet sind und die Realität nicht mehr abbilden? Wie häufig müssen Datensätze aktualisiert werden und wie bekommt man überhaupt mit, dass relevante Stellen neue Informationen veröffentlich haben?

Die Aktualität von Geodaten entscheidet maßgeblich über den Projekterfolg. Veraltete Datensätze können zu Fehlplanungen führen. Etwa, wenn sich Schutzgebietsausweisungen geändert haben, neue Bebauungspläne oder Flurneuordnungsverfahren in Kraft getreten sind. Ein systematisches Monitoring der Datenquellen ist daher unerlässlich. Bundes- und Landesbehörden aktualisieren ihre Geodatenportale in unterschiedlichen Rhythmen – von monatlich bei Flurstücksdaten bis mehrjährig bei Biotopkartierungen.

Wir setzen deshalb immer stärker auf automatisierte Prüfroutinen und pflegen Kontakte zu den relevanten Fachbehörden. Außerdem sind RSS-Feeds, API-Schnittstellen und Newsletter der Geodateninfrastrukturen eine Hilfe.

Datenqualität als Erfolgsfaktor:

Wer versichert, dass die räumlichen Informationen in den Datensätzen grundsätzlich korrekt sind? Welche Geodaten kosten was und warum sind kommerzielle Datenquellen besser als kostenlose?

Nicht alle Geodaten sind gleich geschaffen. Die räumliche Auflösung, Lagegenauigkeit und inhaltliche Vollständigkeit variieren erheblich zwischen den Bezugsquellen. Amtliche Geobasisdaten bieten höchste Präzision bei topographischen Informationen und Flurstücksgrenzen – allerdings gegen Gebühr. Kostenfreie OpenData-Portale liefern oft ausreichende Qualität für Übersichtsanalysen, stoßen aber bei der parzellenscharfen Planung an Grenzen.

Die Investition in kommerzielle Datensätze lohnt sich besonders bei hochauflösenden Satellitenbildern und spezialisierten Fachdaten wie Netzkapazitätsinformationen. Entscheidend ist die Validierung: Plausibilitätsprüfungen, Abgleiche zwischen verschiedenen Datenquellen und reale Erfahrungen im Gelände sichern die Datenintegrität. Denn eine hohe Qualitätsgüte schafft Transparenz und Vertrauen, sowohl intern als auch gegenüber Behörden und Partnern.

Wir bei Wattner leben den Anspruch, Standortanalysen auf ein solides Fundament zu stellen und dafür ist Datenaktualität und -qualität entscheidend. Das erfordert nicht nur kreative Ansätze für automatisierte Prüfroutinen, sondern auch die Sensibilisierung und Schulung unserer Mitarbeiter im Umgang mit Daten sowie den kontinuierlichen Blick auf neue Informationen. Nur so stellen wir sicher, dass jede Standortanalyse die verlässliche Basis für den Erfolg zukünftiger Solarparks bildet.